كشف خبراء الأمن السيبراني عن وجود إضافات خبيثة جديدة في متجر جوجل كروم تم تصميمها خصيصاً لسرقة محادثات ChatGPT و DeepSeek من المستخدمين، في حادثة أمنية خطيرة رصدها فريق تيكبامين ومست أكثر من 900 ألف مستخدم حول العالم.

تأتي هذه الاكتشافات المقلقة لتؤكد تزايد استهداف أدوات الذكاء الاصطناعي، حيث تقوم هذه البرمجيات الخبيثة بنقل بيانات التصفح والمحادثات الخاصة إلى خوادم يسيطر عليها المهاجمون، مما يعرض خصوصية الأفراد والشركات لخطر جسيم.

ما هي الإضافات الخبيثة التي تهدد مستخدمي كروم؟

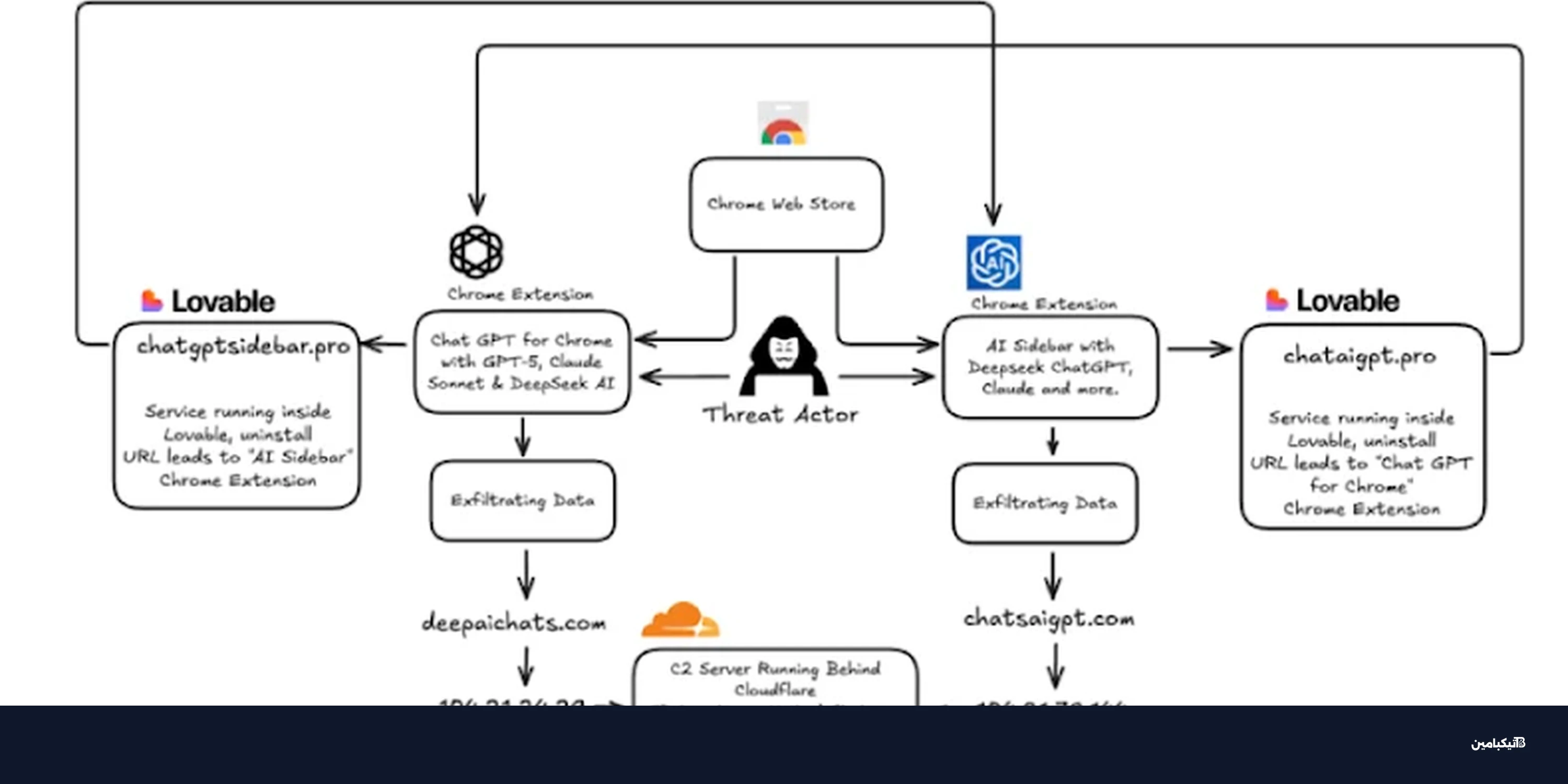

أظهرت التحقيقات التقنية أن الإضافات المكتشفة تنتحل صفة أدوات شرعية ومفيدة لزيادة عدد التحميلات، وهي تستهدف بشكل أساسي مستخدمي نماذج الذكاء الاصطناعي الشهيرة.

وقد وجد الباحثون أن هذه الإضافات تحاول تقليد إضافة شرعية تحمل اسم "Chat with all AI models" تابعة لشركة AITOPIA، ومن بين الأسماء التي استخدمها المخترقون:

- إضافة "Chat GPT for Chrome with GPT-5, Claude Sonnet & DeepSeek AI".

- إضافات أخرى تدعي تحسين تجربة الشريط الجانبي للمتصفح.

ورغم إزالة شارة "متميز" (Featured) عن بعض هذه الإضافات، إلا أنها كانت متاحة للتحميل لفترة كافية للوصول إلى مئات الآلاف من الضحايا، مما يستدعي تدخلاً سريعاً من المستخدمين للمراجعة.

كيف تعمل آلية سرقة محادثات الذكاء الاصطناعي؟

تعتمد هذه البرمجيات على تكتيك خبيث يُطلق عليه اسم "Prompt Poaching"، حيث تبدأ العملية بمجرد تثبيت الإضافة على المتصفح.

وفقاً لتحليل تيكبامين التقني، تعمل البرمجيات الخبيثة وفق الخطوات التالية:

- طلب إذن المستخدم لجمع "بيانات تحليلية مجهولة" بحجة تحسين الخدمة.

- بمجرد الموافقة، يبدأ البرنامج الضار بمراقبة علامات التبويب المفتوحة.

- البحث عن عناصر محددة (DOM elements) داخل صفحات ChatGPT و DeepSeek.

- استخلاص نصوص المحادثات بالكامل وتخزينها محلياً.

- إرسال البيانات المسروقة كل 30 دقيقة إلى خوادم القيادة والتحكم (C2).

استخدام التمويه التقني للخداع

لم يكتفِ المهاجمون بسرقة البيانات، بل استخدموا تقنيات متطورة لإخفاء نشاطهم. فقد تم رصد استخدامهم لمنصة "Lovable"، وهي منصة تطوير ويب تعمل بالذكاء الاصطناعي، لاستضافة سياسات الخصوصية ومكونات البنية التحتية الخاصة بهم.

يساعد هذا التكتيك في جعل النطاقات الخبيثة مثل "chataigpt[.]pro" تبدو وكأنها مواقع شرعية وموثوقة، مما يصعب عملية اكتشافها من قبل برامج الحماية التقليدية.

مخاطر الأمن الرقمي وتوصيات الحماية

تتجاوز خطورة هذه الهجمات مجرد قراءة دردشة عابرة، حيث تتضمن البيانات المسروقة معلومات حساسة للغاية قد تشمل أسراراً تجارية أو بيانات شخصية دقيقة.

ويمكن تلخيص المخاطر الرئيسية فيما يلي:

- التجسس المؤسسي: تسريب عناوين URL الداخلية للشركات واستفسارات البحث الحساسة.

- سرقة الهوية: استخدام المعلومات الشخصية الواردة في المحادثات لانتحال الشخصية.

- هجمات التصيد: استغلال محتوى الدردشة لشن حملات تصيد موجهة ودقيقة.

ينصح خبراء تيكبامين جميع المستخدمين بمراجعة إضافات متصفح كروم المثبتة لديهم فوراً، وإزالة أي إضافة غير ضرورية أو مشكوك في مصدرها، خاصة تلك التي تطلب صلاحيات واسعة للوصول إلى بيانات المواقع التي تزورها.