نعيش اليوم في خضم أزمة حقيقية تتعلق بمفهوم الواقع، حيث أصبحت الصور ومقاطع الفيديو التي نلتقطها بهواتفنا تخضع لمعالجة رقمية مكثفة، وتداخلت الحدود بين ما هو حقيقي وما هو مولّد بواسطة الذكاء الاصطناعي.

ما هي أزمة التزييف العميق الحالية؟

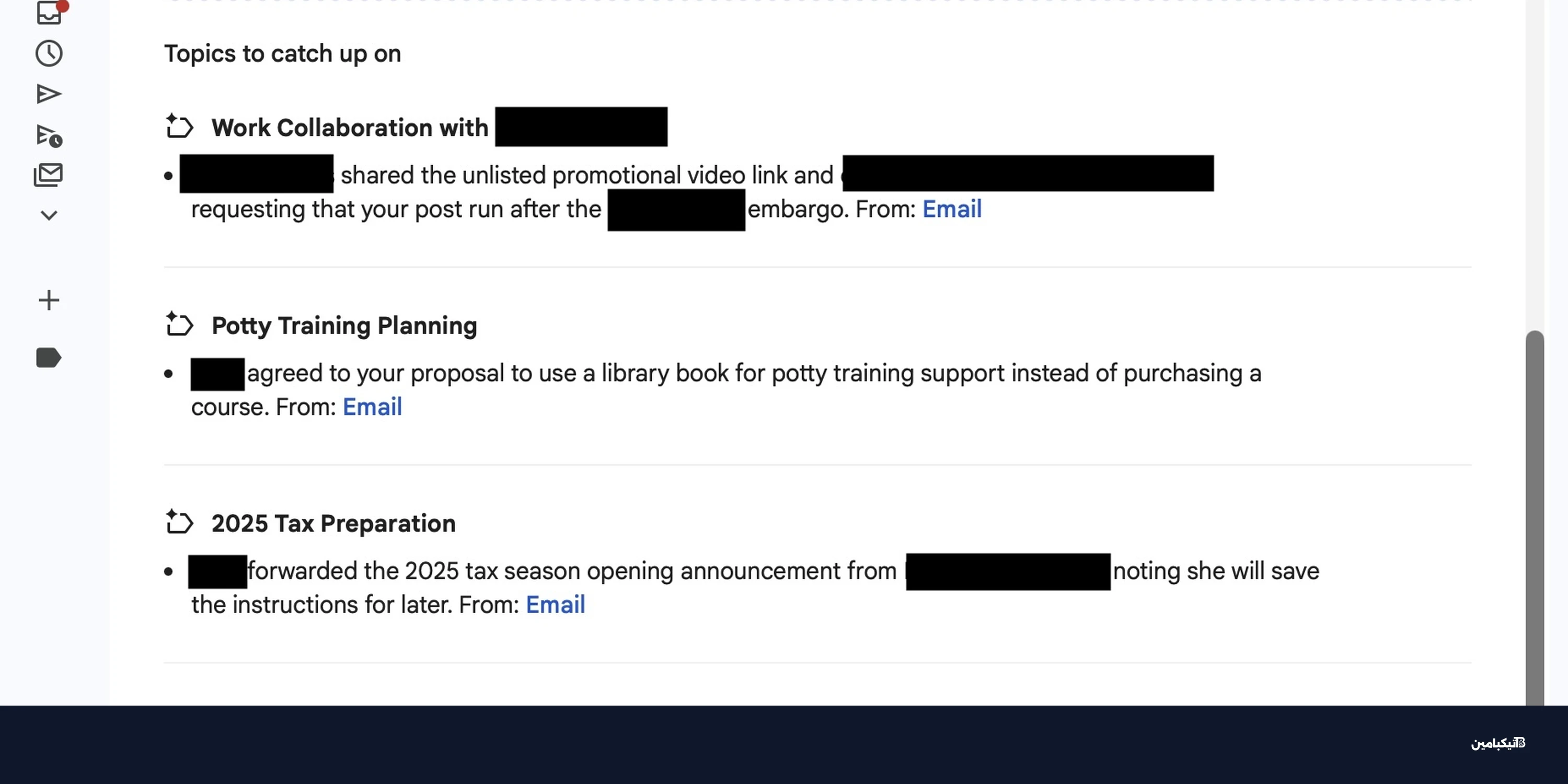

في عام 2026، يشير تقرير نشره موقع تيكبامين إلى أننا نواجه تدفقاً هائلاً من الصور ومقاطع الفيديو المزيفة فائقة الواقعية التي تغرق منصات التواصل الاجتماعي. يتم نشر هذه المحتويات دون أي اعتبار للمسؤولية أو المعايير الأخلاقية، لدرجة أننا شهدنا صوراً متلاعباً بها لشخصيات عامة يتم تداولها كحقائق، مما يضعنا أمام تحدٍ غير مسبوق في تمييز الحقيقة.

ما هي تقنية C2PA وكيف تعمل؟

يتساءل الكثيرون عن سبب غياب نظام موحد يساعد الناس على التمييز بين الصور الحقيقية والمزيفة. الحل الأكثر زخماً حالياً هو مبادرة تُعرف باسم C2PA، وهي معيار تقني لوضع علامات أو "بيانات اعتماد" للمحتوى الرقمي.

تحظى هذه المبادرة بدعم كبرى الشركات التقنية في العالم، ومن أبرزها:

- شركة أدوبي (Adobe) التي تقود المبادرة.

- شركة ميتا (فيسبوك وإنستجرام).

- شركة مايكروسوفت.

- شركة OpenAI المطورة لـ ChatGPT.

لماذا تواجه أدوات كشف التزييف صعوبات؟

رغم الزخم الكبير، تعاني تقنية C2PA من عيوب جوهرية قد تحد من فاعليتها، كما يرى الخبراء. المشكلة الأساسية تكمن في طبيعة التصميم والتطبيق:

- تم تصميمها كأداة لبيانات وصفية (Metadata) للتصوير الفوتوغرافي، وليست كنظام كشف تلقائي للذكاء الاصطناعي.

- التبني التقني لا يزال جزئياً ومتردداً من قبل اللاعبين الرئيسيين في الإنترنت.

- غياب التوافق الشامل يعني وجود ثغرات كبيرة تسمح بمرور المحتوى المزيف.

هل انتهى زمن الثقة بالصور الرقمية؟

وصلنا إلى مرحلة صرح فيها آدم موسيري، رئيس إنستجرام، بأن الوضع الافتراضي يجب أن يتغير، حيث لم يعد بإمكاننا الوثوق بالصور أو مقاطع الفيديو كما كنا نفعل في السابق. هذا يمثل تحولاً محورياً في كيفية تقييم المجتمع للمحتوى المرئي.

في الختام، يبدو أن المعركة ضد التزييف العميق تتطلب أكثر من مجرد أدوات تقنية؛ إنها تتطلب وعياً مجتمعياً جديداً، وكما نتابع في تيكبامين، فإن التطور في هذا المجال لا يتوقف.